2025年12月9日から12月12日にわたって台湾台北市で開催された「The 17th Asian Conference on Machine Learning (ACML 2025)」に参加しました。本ACMLは機械学習に関する難関国際会議として知られており、今年の採択率は28.5%でした。

毎年11月中旬~12月中旬頃に開催されるACMLでは最適化論等の理論研究や大規模言語モデル、画像処理、およびバイオインフォマティクス等の応用研究など広範なトピックが扱われます。今回の会議ではアジアを中心とし、世界中から参加者が集まり活発な議論が行われました。

ACML 2025において、貴財団から国際交流助成をいただいた本論文「Faster Convergence of Riemannian Stochastic Gradient Descent with Increasing Batch Size」が「Best Paper Runner-up Award」を受賞いたしました。ACML 2025に投稿された375本の論文の内107本の論文が採択され(28.5%)、査読得点4点中3.75点以上を獲得した上位9本の論文から、審査委員会の厳正な審査の末、「Best Paper Award」(1件)と「Best Paper Runner-up Award」(1件)が選出されました。

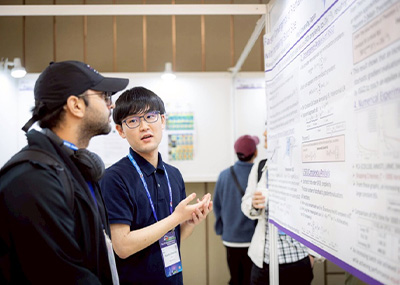

「Faster Convergence of Riemannian Stochastic Gradient Descent with Increasing Batch Size」というタイトルで20分の口頭発表および90分のポスター発表の両方を行いました。近年、AIモデルのパラメータは巨大化の一途を辿り、ChatGPTやGoogle Geminiをはじめとした大規模言語モデルは推定1兆次元程度のパラメータを持つと言われています。このような中、全データを用いて勾配を計算し、それを利用して点列を更新する勾配降下法をモデルの学習へ適用することは非現実的です。そこで、全てではなく一部のデータをサンプリングし、それらを用いた勾配であるミニバッチ勾配を探索方向の代替として利用する確率的勾配降下法がモデルの学習に広く使用されます。サンプリングするデータの個数をバッチサイズといいます。今述べた確率的勾配降下法の登場の経緯を踏まえれば、バッチサイズの設定は非常に重要な実用的課題です。本研究では増加バッチサイズというバッチサイズスケジューラを考察し、増加バッチサイズが確率的勾配の計算回数(SFO複雑度)を削減し、結果として計算量を大幅に減らすことを理論的に証明しました。これは世界初の革新的な結果です。この結果は増加バッチサイズが計算時間を短縮させることを示唆しており、このことを実験的に裏付けることにも成功しました。具体的には増加バッチサイズが、従来用いられてきた定数バッチサイズと同等かそれ以上の精度の近似解を達成し、かつ計算時間を1/10~1/3倍に短縮することを数値実験で示しました。

質問は主に、増加バッチサイズの定義、SFO複雑度を削減する主定理の内容、数値実験、および実装コードについてでした。

国際会議参加どころか海外に行くこと自体が初めての体験であったため、海外の文化や人々と交流するとても良い経験になりました。ACML 2025での議論を通して多くの好意的な意見をいただいたり、ポスター発表を興味深く聴いていただいたりと手応えを感じる場面が多く自分の研究が世界にも通用するのだと自信に繋がりました。さらに、今回受賞した「Best Paper Runner-up Award」はこの手応えを裏付けるものと捉えられ、今後の研究活動に対する大きな励みになりました。一方で、英語力の不足を痛感しました。事前に想定していた分は英語で議論ができたのですが、それ以外になると英語がうまく出てこない場面があり大変悔しい思いをしました。しかしながらこの経験によって、英語を操り世界中の研究者と深い部分まで十二分に議論をしたいという強い憧れができ、英会話をより勉強するためのモチベーションになりました。

この度、国際会議参加に際し貴財団に頂いた多大なるご支援、幸甚の極みに存じます。ACML 2025への参加で得た経験は今後の研究活動および国際交流に対し、とても大きな意味を持つものであると確信しています。改めて、心より御礼申し上げます。